Un team di ricercatori dell’Università di Twente, guidato da Michael Ying Yang, ha sviluppato un metodo innovativo che permette di creare rappresentazioni visive complete a partire da immagini. Questo avanzamento nell’Intelligenza Artificiale (IA) ha il potenziale di generare immagini realistiche e coerenti, migliorando al contempo la capacità dei computer di rilevare e comprendere le relazioni visive tra gli oggetti. Lo studio, pubblicato di recente sulla rivista IEEE Transactions on Pattern Analysis and Machine Intelligence, mostra come questo nuovo approccio potrebbe avere applicazioni non solo nella generazione di immagini, ma anche nella percezione dei veicoli autonomi e dei robot.

Rilevando relazioni in modo efficiente

I modelli generativi di IA sono in grado di creare immagini a partire da indicazioni testuali, ma le loro prestazioni diminuiscono quando si tratta di generare scene complete invece di singoli oggetti. Questo perché gli esseri umani sono eccezionali nell’identificare le relazioni tra gli oggetti, come distinguere se una sedia è sopra il pavimento o se un cane cammina per strada, mentre i modelli di IA incontrano difficoltà in questo compito.

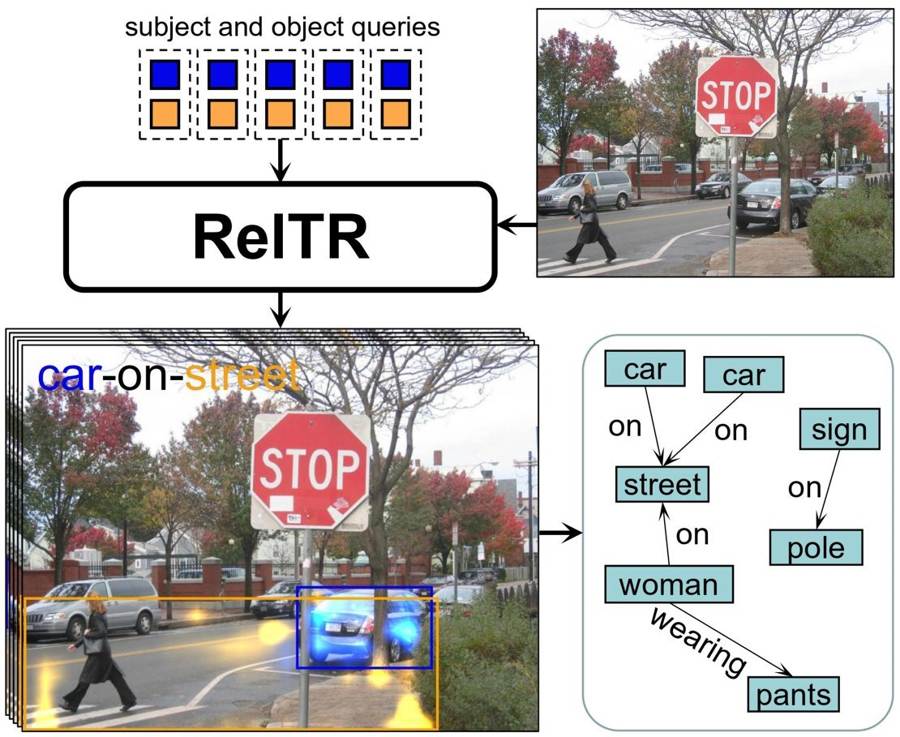

Fino ad ora, i metodi esistenti per rappresentare graficamente una comprensione semantica di un’immagine utilizzavano un approccio a due fasi. Nella prima fase, venivano mappati tutti gli oggetti presenti nella scena, e nella seconda fase, veniva utilizzata una rete neurale per esaminare le diverse possibili connessioni ed etichettarle con la relazione corretta. Tuttavia, questo approccio diventa lento e computazionalmente costoso man mano che aumenta il numero di oggetti nella scena.

Un passo verso l’efficienza: il metodo a singola fase

Il nuovo metodo proposto dal team di ricerca dell’Università di Twente riduce la complessità eseguendo l’intero processo in una sola fase. Invece di cercare esaustivamente tutte le possibili connessioni, il modello si concentra sulle caratteristiche visive degli oggetti presenti nella scena e evidenzia i dettagli rilevanti per determinare le relazioni. Ciò implica evidenziare le aree in cui gli oggetti interagiscono o sono correlati tra loro. Attraverso tecniche di addestramento e utilizzando una quantità relativamente piccola di dati, il modello riesce a identificare le relazioni più importanti tra i diversi oggetti.

Ad esempio, il modello può rilevare che in un’immagine specifica è molto probabile che un uomo stia interagendo con una mazza da baseball. Successivamente, il modello viene addestrato a descrivere la relazione più probabile tra di loro, come “uomo-colpisce-mazza da baseball”. Questo approccio semplifica il processo di comprensione delle scene e fornisce un quadro che può essere utilizzato per generare immagini realistiche e coerenti.

Implicazioni e future applicazioni

L’avanzamento nella generazione di scene a partire da immagini ha un grande potenziale in diversi campi della tecnologia. Oltre a facilitare la creazione di immagini realistiche, questo approccio potrebbe anche migliorare la percezione dei veicoli autonomi e dei robot consentendo loro di comprendere e interagire con il loro ambiente in modo più efficace. Ad esempio, un’auto autonoma potrebbe utilizzare questo metodo per identificare e ragionare sulle relazioni tra gli oggetti presenti sulla strada, migliorando così la sua capacità di prendere decisioni ed evitare possibili pericoli.

Il rivoluzionario metodo sviluppato dal team di ricerca dell’Università di Twente rappresenta un significativo avanzamento nella generazione di scene a partire da immagini. Semplificando il processo di rilevamento delle relazioni e migliorando la comprensione visiva degli oggetti in un’immagine, questo approccio promette ampie applicazioni nei campi dell’intelligenza artificiale, della visione artificiale e della robotica. Man mano che la tecnologia avanza, possiamo aspettarci che le macchine siano in grado di interpretare e comprendere il nostro ambiente visivo in modo più simile a come lo fanno gli esseri umani.